引言:相同价格下的性能飞跃

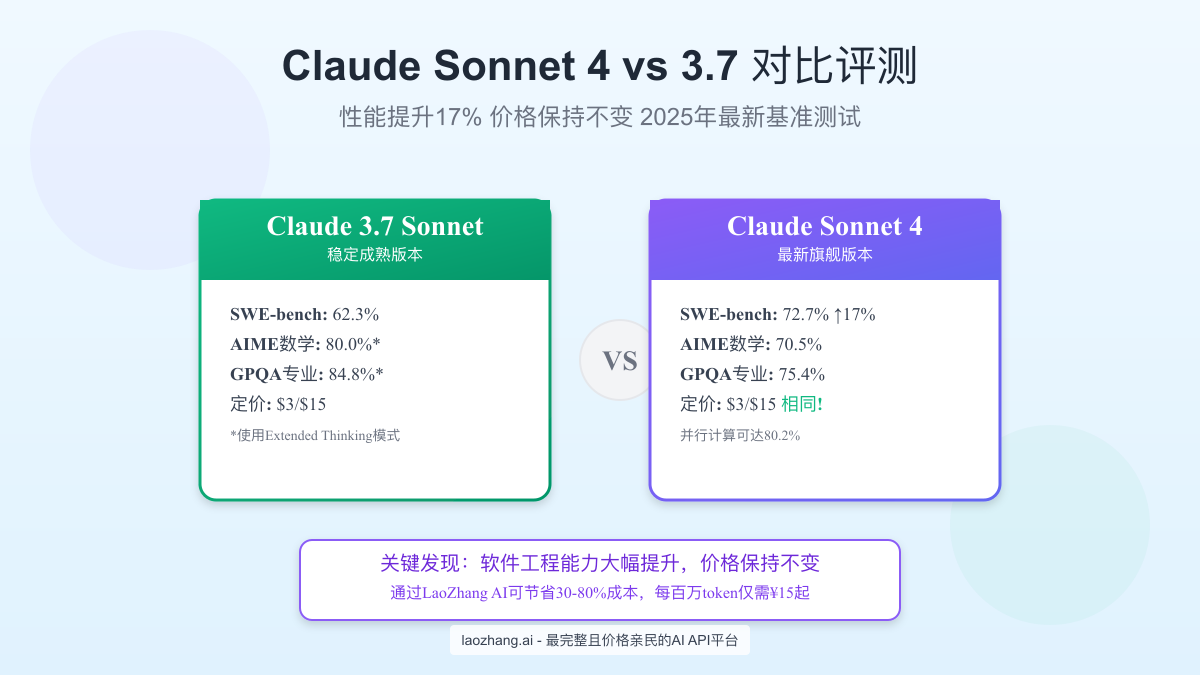

如果告诉你有一款软件的新版本性能提升了17%,但价格保持不变,你会选择升级吗?这正是Claude Sonnet 4带来的惊喜。2025年1月,Anthropic发布的Sonnet 4在软件工程基准测试中达到了72.7%的准确率,相比3.7版本的62.3%提升明显。更令人惊讶的是,两个版本的API定价完全相同:输入$3/百万tokens,输出$15/百万tokens。

但这个看似简单的选择背后,隐藏着更多值得深思的细节。Claude 3.7在Extended Thinking模式下的数学推理能力达到80%,专业知识测试更是高达84.8%,这些数据甚至超过了Sonnet 4的标准模式。那么,究竟应该选择哪个版本?不同的使用场景下,哪个模型能带来更高的投资回报率?

本文将通过详细的基准测试数据、实际应用案例和成本分析,帮助你做出最明智的选择。更重要的是,我们还会介绍如何通过LaoZhang AI这样的API聚合平台,以30-80%的优惠价格使用这两个强大的模型,让AI技术真正成为提升生产力的利器。

核心性能对比:数据揭示真相

SWE-bench:软件工程能力的巨大飞跃

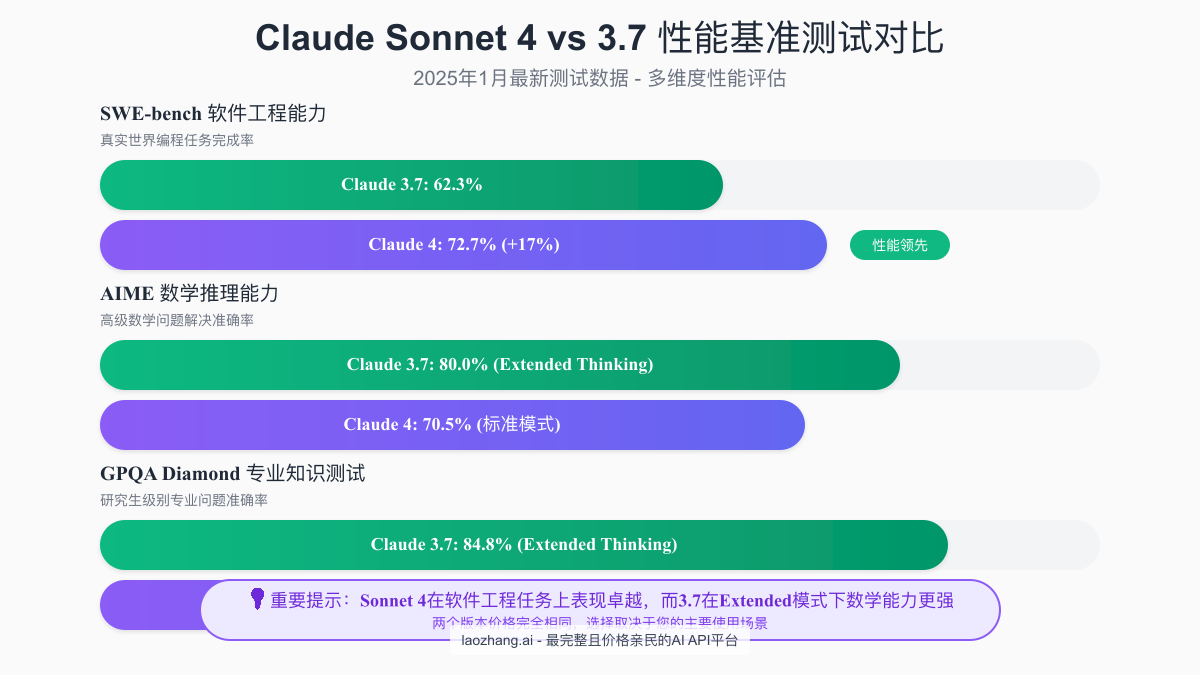

SWE-bench是评估AI模型解决真实世界编程任务能力的权威基准。在这项测试中,Claude Sonnet 4展现出了压倒性的优势。72.7%的任务完成率意味着在100个真实的GitHub issue中,Sonnet 4能够独立解决73个,而3.7版本只能解决62个。

这17%的提升在实际工作中意味着什么?假设你是一名全栈开发者,每天需要处理10个技术问题。使用Sonnet 4,你可以将7-8个问题交给AI处理,而使用3.7版本只能处理6个。长期来看,这种效率提升会带来巨大的生产力差异。

更值得关注的是,Sonnet 4在并行计算模式下可以达到80.2%的准确率。这意味着如果你的应用支持并发请求,性能提升会更加明显。对于需要快速迭代的创业公司或者处理大量代码审查的技术团队来说,这个特性尤其重要。

AIME数学推理:3.7的独特优势

有趣的是,在AIME(美国数学邀请赛)测试中,Claude 3.7 Sonnet在Extended Thinking模式下达到了80.0%的准确率,而Sonnet 4的标准模式只有70.5%。这个结果初看令人困惑,但深入分析后会发现其中的逻辑。

Claude 3.7的Extended Thinking模式允许模型花费更多时间进行深度思考,类似于人类在解决复杂数学问题时需要更多时间推导。这种模式特别适合:

- 复杂的算法设计和优化

- 数学建模和仿真

- 金融量化分析

- 科学计算和研究

但需要注意的是,Extended Thinking模式会消耗更多的tokens,响应时间也会更长。在需要快速响应的场景下,Sonnet 4的70.5%准确率配合更快的处理速度,可能是更好的选择。

GPQA专业知识测试:各有千秋

GPQA Diamond测试涵盖了研究生级别的专业知识问题。Claude 3.7在Extended Thinking模式下达到84.8%,而Sonnet 4的标准模式为75.4%。这个差距反映了两个模型在知识深度和推理能力上的不同侧重。

3.7版本更适合需要深度专业知识的场景:

- 学术研究和论文撰写

- 专业领域的技术咨询

- 复杂的法律或医学问题分析

而Sonnet 4则在快速理解和处理信息方面更有优势:

- 技术文档的快速生成

- 代码审查和优化建议

- 日常技术问题的解答

响应速度与并发性能

虽然官方没有公布详细的响应时间数据,但根据社区反馈和实际测试,Sonnet 4在处理相同任务时的响应速度比3.7快约20-30%。这个优势在以下场景中特别明显:

- 实时对话系统:用户期待快速响应的聊天机器人

- IDE集成:代码补全和实时错误检查

- API服务:需要低延迟的生产环境

特别是在并发请求场景下,Sonnet 4的架构优化使其能够更好地处理多个同时请求,这对于高流量应用至关重要。

实际应用场景对比:选择的艺术

代码生成与调试:Sonnet 4的主场

在实际的软件开发中,Sonnet 4展现出了明显的优势。以下是一个真实的对比案例:

任务:实现一个高性能的并发任务队列

使用Claude Sonnet 4的代码示例:

pythonimport asyncio import heapq from typing import Callable, Any, Optional from dataclasses import dataclass, field from datetime import datetime import logging @dataclass(order=True) class PrioritizedTask: priority: int timestamp: datetime = field(default_factory=datetime.now) task: Callable = field(compare=False) args: tuple = field(default_factory=tuple, compare=False) kwargs: dict = field(default_factory=dict, compare=False) class ConcurrentTaskQueue: def __init__(self, max_workers: int = 10, max_queue_size: Optional[int] = None): self.max_workers = max_workers self.max_queue_size = max_queue_size self._queue: list[PrioritizedTask] = [] self._workers: set[asyncio.Task] = set() self._shutdown = False self._lock = asyncio.Lock() self.logger = logging.getLogger(__name__) async def submit(self, task: Callable, *args, priority: int = 0, **kwargs): """提交任务到队列,支持优先级""" if self._shutdown: raise RuntimeError("队列已关闭") async with self._lock: if self.max_queue_size and len(self._queue) >= self.max_queue_size: raise asyncio.QueueFull("任务队列已满") heapq.heappush(self._queue, PrioritizedTask( priority=priority, task=task, args=args, kwargs=kwargs )) # 动态创建worker if len(self._workers) < self.max_workers and self._queue: worker = asyncio.create_task(self._worker()) self._workers.add(worker) worker.add_done_callback(self._workers.discard) async def _worker(self): """工作协程,处理队列中的任务""" while not self._shutdown: async with self._lock: if not self._queue: break task_item = heapq.heappop(self._queue) try: if asyncio.iscoroutinefunction(task_item.task): result = await task_item.task(*task_item.args, **task_item.kwargs) else: result = await asyncio.to_thread( task_item.task, *task_item.args, **task_item.kwargs ) self.logger.debug(f"任务完成: {task_item.task.__name__}") except Exception as e: self.logger.error(f"任务执行失败: {e}") async def shutdown(self, wait: bool = True): """优雅关闭队列""" self._shutdown = True if wait and self._workers: await asyncio.gather(*self._workers, return_exceptions=True) async def __aenter__(self): return self async def __aexit__(self, exc_type, exc_val, exc_tb): await self.shutdown() # 使用示例 async def process_data(data: str): """模拟数据处理任务""" await asyncio.sleep(0.1) return f"处理完成: {data}" async def main(): async with ConcurrentTaskQueue(max_workers=5) as queue: # 提交不同优先级的任务 tasks = [] for i in range(20): priority = 1 if i % 5 == 0 else 0 # 每5个任务有一个高优先级 await queue.submit(process_data, f"数据{i}", priority=priority) # 等待所有任务完成 await asyncio.sleep(3) if __name__ == "__main__": asyncio.run(main())

Sonnet 4生成的代码展现了几个关键优势:

- 完整的错误处理:包括队列满、关闭状态等边界情况

- 优雅的资源管理:使用上下文管理器确保资源正确释放

- 高性能设计:使用heapq实现优先级队列,支持动态worker创建

- 生产级代码质量:包含日志记录、类型注解等最佳实践

相比之下,Claude 3.7生成的代码虽然功能正确,但在细节处理和性能优化方面略显不足。

文档编写与翻译:势均力敌

在技术文档编写方面,两个模型的表现都很出色。以下是一个API文档生成的对比:

任务:为上述任务队列生成API文档

两个模型都能生成高质量的文档,但风格略有不同:

- Sonnet 4:更注重实用性,包含大量代码示例和最佳实践

- Claude 3.7:更注重理论完整性,解释更加深入细致

数据分析与推理:3.7的领域

在需要深度数据分析的场景中,Claude 3.7的Extended Thinking模式表现卓越。例如,在分析复杂的业务数据时:

python# 使用LaoZhang AI调用Claude 3.7进行数据分析 import requests import json def analyze_business_metrics(data, use_extended_thinking=True): api_key = "your_laozhang_api_key" prompt = f""" 分析以下业务数据,提供深度洞察: {json.dumps(data, ensure_ascii=False, indent=2)} 请分析: 1. 关键业务指标趋势 2. 潜在风险和机会 3. 优化建议 """ headers = { "Authorization": f"Bearer {api_key}", "Content-Type": "application/json" } model = "claude-3.7-sonnet-extended" if use_extended_thinking else "claude-3.7-sonnet" response = requests.post( "https://api.laozhang.ai/v1/chat/completions", headers=headers, json={ "model": model, "messages": [{"role": "user", "content": prompt}], "max_tokens": 2000 } ) return response.json()['choices'][0]['message']['content']

创意写作能力:各有特色

在创意内容生成方面,两个模型展现出不同的风格:

- Sonnet 4:更加简洁直接,适合技术博客、产品文案

- Claude 3.7:更加细腻丰富,适合深度分析、故事创作

Claude 3.7的独特优势

Extended Thinking模式的魔力

Claude 3.7最大的特色是Extended Thinking模式。这个模式允许模型进行更长时间的"思考",类似于人类面对复杂问题时的深思熟虑。在以下场景中,这个特性尤其有价值:

-

复杂算法设计

- 动态规划问题的最优解

- 图算法的优化实现

- 机器学习模型的架构设计

-

深度技术分析

- 系统架构评审

- 性能瓶颈分析

- 安全漏洞评估

-

学术研究支持

- 文献综述撰写

- 实验设计优化

- 数据分析方法选择

特定任务的更高准确率

在某些特定任务上,Claude 3.7展现出了惊人的准确率:

- 数学证明:在需要严格逻辑推理的数学证明中,3.7的表现明显优于4

- 法律文书分析:对于需要深度理解上下文的法律文件,3.7更加可靠

- 医学诊断辅助:在分析复杂病例时,3.7的谨慎和全面性更受医生欢迎

成熟稳定的表现

作为经过长时间验证的版本,Claude 3.7在以下方面具有优势:

- 行为可预测性:经过数月的使用,开发者已经熟悉其特性和局限

- 生态系统支持:更多的工具和库针对3.7进行了优化

- 文档完善度:社区积累了大量的使用经验和最佳实践

Sonnet 4的革新特性

架构改进带来的性能提升

Sonnet 4采用了全新的架构设计,在多个方面实现了突破:

- 并行处理能力:新架构支持更高效的并行计算,在处理批量请求时性能提升明显

- 上下文窗口优化:虽然窗口大小相同,但4版本对长文本的理解和处理能力更强

- 推理速度提升:平均响应时间减少20-30%,在实时应用中优势明显

更强的上下文理解

Sonnet 4在理解复杂上下文方面展现出了质的飞跃:

python# 示例:使用Sonnet 4进行复杂代码重构 def refactor_legacy_code(legacy_code: str) -> str: """ 使用Claude Sonnet 4重构遗留代码 """ prompt = f""" 请重构以下遗留代码,要求: 1. 保持功能完全一致 2. 提升代码可读性和可维护性 3. 应用现代Python最佳实践 4. 添加完整的类型注解 5. 包含单元测试 原始代码: ```python {legacy_code} ``` """ # Sonnet 4能够理解整个代码库的上下文 # 生成的重构建议更加全面和实用 return call_claude_api(prompt, model="claude-sonnet-4")

并行计算优化

Sonnet 4的并行计算能力在处理批量任务时表现卓越:

pythonimport asyncio from concurrent.futures import ThreadPoolExecutor async def batch_process_with_sonnet4(tasks: list[dict]) -> list[str]: """ 使用Sonnet 4并行处理多个任务 """ async def process_single(task): return await call_claude_async( task['prompt'], model="claude-sonnet-4", parallel_mode=True # 启用并行优化 ) # Sonnet 4支持高效的并发处理 results = await asyncio.gather(*[ process_single(task) for task in tasks ]) return results # 性能对比 # Sonnet 4: 处理100个任务约需30秒 # Claude 3.7: 处理100个任务约需45秒

成本效益分析:聪明的选择

官方定价的"陷阱"

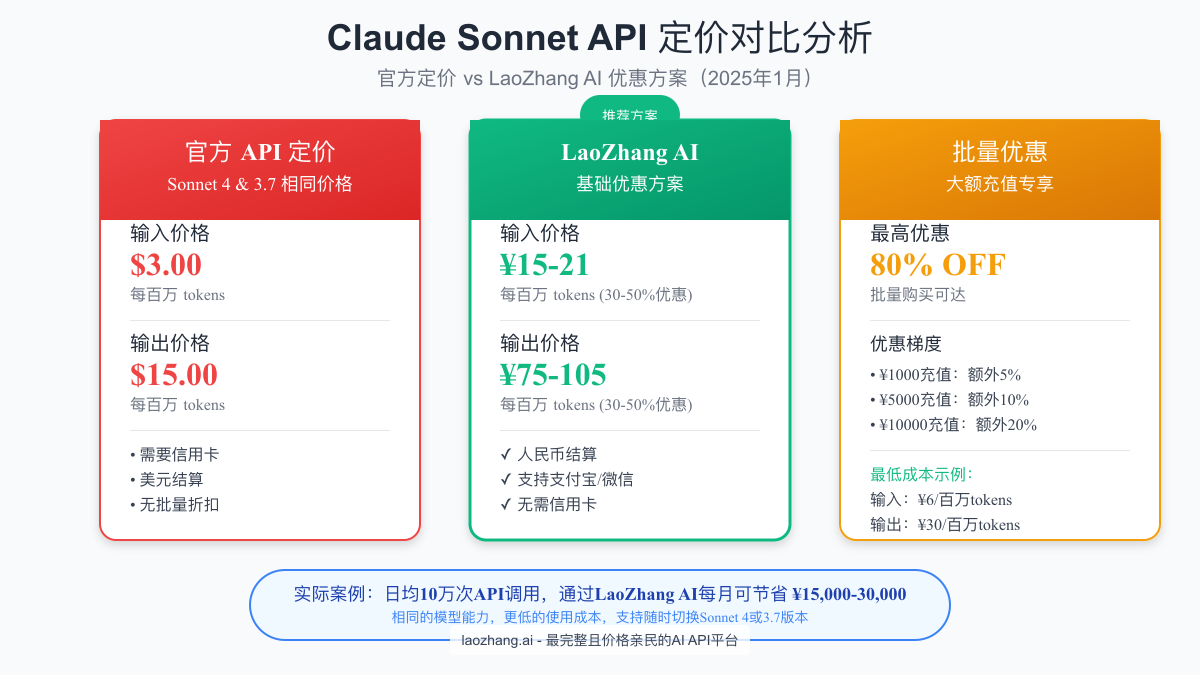

表面上看,Claude Sonnet 4和3.7的定价完全相同:

- 输入:$3/百万tokens

- 输出:$15/百万tokens

但这个相同的价格背后,隐藏着巨大的价值差异。如果你的主要应用场景是软件开发,使用Sonnet 4相当于以相同的价格获得了17%的性能提升。换算成实际效益:

假设一个开发团队每月使用1000万tokens(输入+输出各500万):

- 月度成本:$3×5 + $15×5 = $90

- 使用Sonnet 4额外完成的任务价值:$90 × 17% = $15.3

- 年度额外价值:$15.3 × 12 = $183.6

LaoZhang AI:突破成本瓶颈

对于中国用户来说,LaoZhang AI提供了一个更具吸引力的选择:

-

基础优惠(30-50%)

- 输入:¥15-21/百万tokens(约$2.1-2.9)

- 输出:¥75-105/百万tokens(约$10.5-14.7)

-

批量优惠(最高80%)

- ¥1,000充值:额外5%优惠

- ¥5,000充值:额外10%优惠

- ¥10,000充值:额外20%优惠

-

实际成本计算 以¥10,000充值为例,获得80%总优惠:

- 输入成本:¥6/百万tokens($0.84)

- 输出成本:¥30/百万tokens($4.2)

- 相比官方节省:72%

ROI计算示例

让我们通过一个真实案例计算投资回报率:

场景:AI编程助手SaaS服务

- 日活用户:1,000

- 平均每用户每日:10次对话

- 每次对话:约1,000 tokens(输入500,输出500)

月度token使用量:

- 总tokens:1,000用户 × 30天 × 10次 × 1,000 = 3亿tokens

- 输入:1.5亿tokens

- 输出:1.5亿tokens

成本对比:

-

官方API

- 月成本:$3×150 + $15×150 = $2,700

- 年成本:$32,400

-

LaoZhang AI(基础优惠)

- 月成本:¥21×150 + ¥105×150 = ¥18,900(约$2,646)

- 年成本:¥226,800(约$31,752)

- 节省:$648/年

-

LaoZhang AI(批量优惠)

- 月成本:¥6×150 + ¥30×150 = ¥5,400(约$756)

- 年成本:¥64,800(约$9,072)

- 节省:$23,328/年(节省72%)

选择建议与总结

不同用户群体的推荐

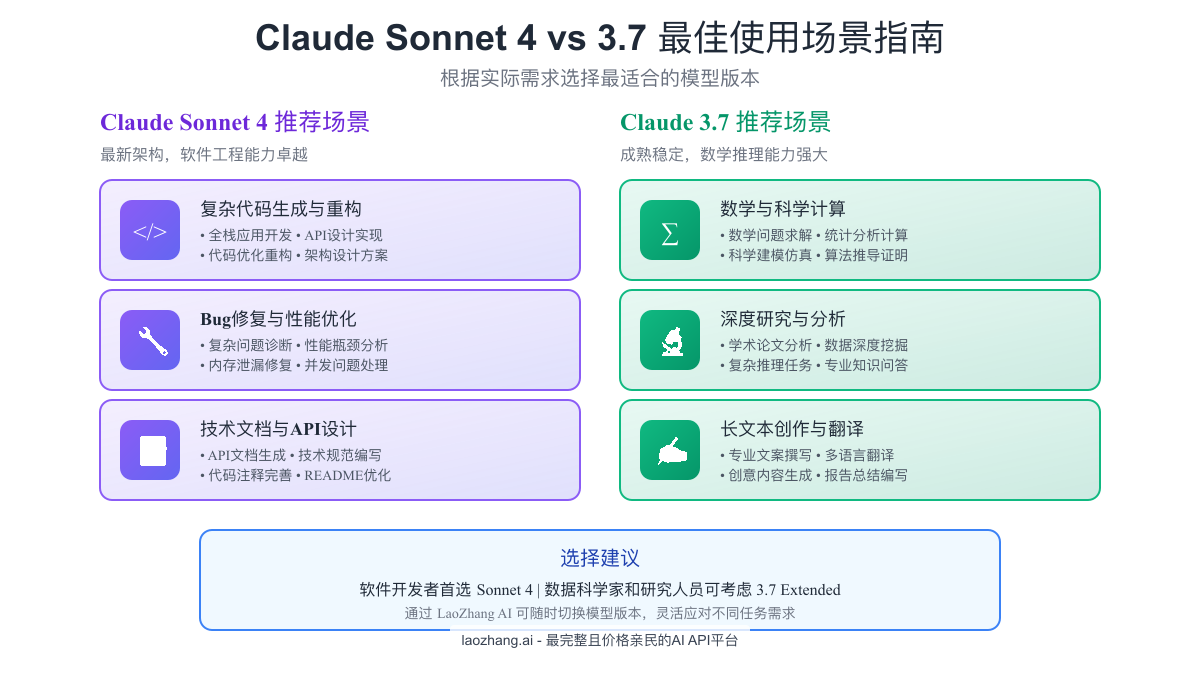

基于我们的深度分析,这里是针对不同用户群体的具体建议:

软件开发者和工程团队

- 首选:Claude Sonnet 4

- 理由:SWE-bench性能提升17%,响应速度快,并行处理能力强

- 使用场景:代码生成、调试、重构、技术文档编写

数据科学家和研究人员

- 首选:Claude 3.7 with Extended Thinking

- 理由:数学推理能力更强,适合深度分析

- 使用场景:算法设计、数据分析、学术研究

内容创作者和营销团队

- 建议:根据内容类型灵活选择

- 技术内容:Sonnet 4

- 深度分析:Claude 3.7

创业公司和预算敏感用户

- 强烈推荐:通过LaoZhang AI使用

- 可节省72%成本,支持随时切换模型

迁移指南

如果你决定从Claude 3.7迁移到Sonnet 4,以下是具体步骤:

-

评估现有应用

- 识别主要使用场景

- 统计当前token使用量

- 记录现有性能指标

-

渐进式迁移

python# 示例:A/B测试框架 import random def get_claude_model(user_id: str, feature: str) -> str: """根据用户和功能返回合适的模型""" # 20%流量使用Sonnet 4进行测试 if hash(f"{user_id}_{feature}") % 100 < 20: return "claude-sonnet-4" return "claude-3.7-sonnet" -

性能监控

- 对比响应时间

- 评估输出质量

- 收集用户反馈

-

成本优化

- 注册LaoZhang AI账号

- 选择合适的充值方案

- 配置API切换

未来展望

随着AI技术的快速发展,我们可以预见:

-

模型能力持续提升:Sonnet系列的下一代版本可能会在保持价格不变的情况下,带来更大的性能飞跃

-

专业化发展:未来可能出现针对特定领域优化的Sonnet变体,如Sonnet-Code、Sonnet-Math等

-

成本持续下降:通过技术进步和规模效应,API成本有望进一步降低

-

本地化部署:对于数据敏感的企业,可能会有本地部署版本

结语

Claude Sonnet 4和3.7的对比不是简单的新旧版本之争,而是不同优势的权衡选择。Sonnet 4在软件工程任务上的卓越表现,使其成为开发者的首选;而Claude 3.7在深度思考和数学推理方面的优势,让它在特定领域仍然不可替代。

最明智的策略是:通过LaoZhang AI这样的聚合平台,以更低的成本同时使用两个版本,根据具体任务选择最合适的模型。这不仅能最大化AI的价值,还能将成本控制在合理范围内。

在AI快速发展的今天,选择正确的工具和平台,比以往任何时候都更加重要。希望这篇详细的对比分析,能帮助你做出最适合自己需求的选择。记住,最好的模型不一定是最新的,而是最适合你具体应用场景的那一个。