Google的Gemini 2.5系列模型凭借其强大的多模态理解能力和卓越的推理表现,已成为全球领先的大语言模型之一。尤其是最新的Gemini 2.5 Pro更是在各项基准测试中表现出色,支持100万令牌的超长上下文窗口和思考链功能,为开发者提供了前所未有的AI能力。然而,由于众所周知的原因,中国大陆开发者在直接访问Google服务时面临着诸多挑战。

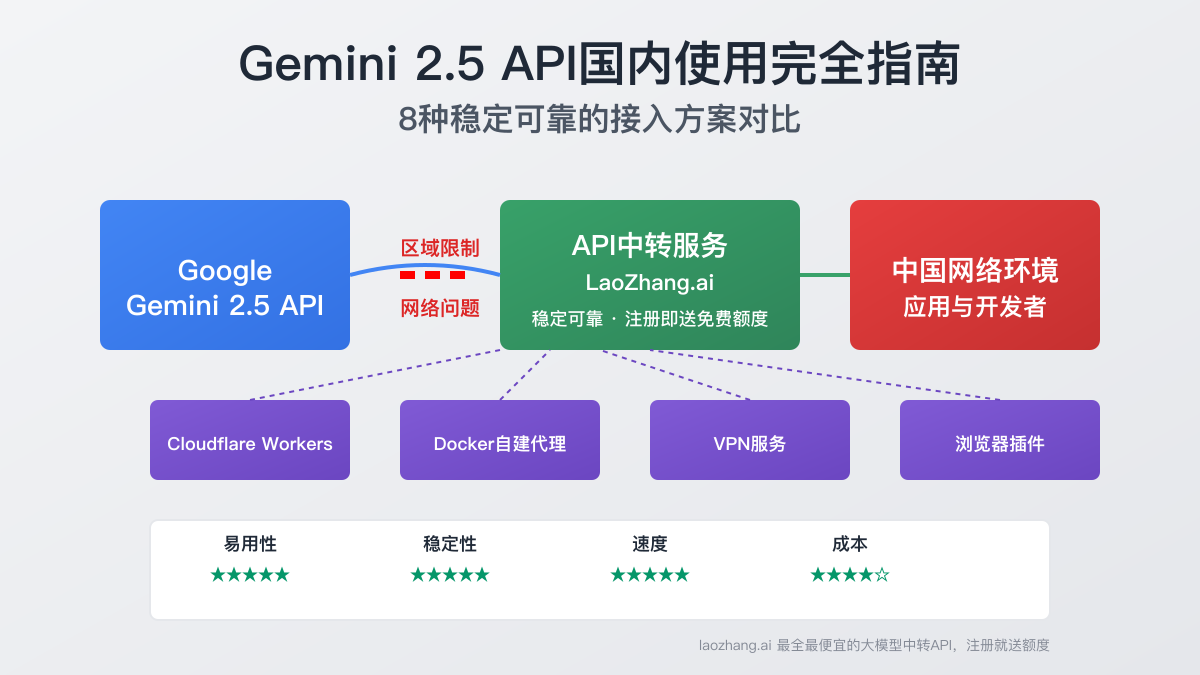

本文将全面剖析国内使用Gemini 2.5 API的主要障碍,并提供8种实测有效的解决方案,从易用性、稳定性、成本和性能四个维度进行比较,帮助开发者选择最适合自己需求的接入方式。

一、国内用户使用Gemini API面临的主要障碍

通过技术调研,我们发现国内开发者在使用Gemini API时主要面临三大关键问题:

1. 区域限制策略

Google对Gemini API实施了严格的区域可用性限制。根据官方文档,中国大陆地区不在支持列表内,直接访问API时会返回区域限制错误。这种限制在API密钥申请和服务调用两个阶段都会遇到。

2. 网络连接不稳定

即使通过某些方法绕过了区域限制,中国大陆用户仍然面临网络连接问题。直接连接Google API服务器通常表现为高延迟、频繁超时或完全无法访问,严重影响服务稳定性和用户体验。

3. 账号与支付限制

使用官方Gemini API需要:

- 有效的Google账号

- 非中国大陆地区的手机号码进行验证

- 国际信用卡进行付费账户验证

这些要求为中国开发者设置了较高的使用门槛。

二、Gemini 2.5系列模型特性与价值

在讨论解决方案前,让我们先了解Gemini 2.5系列模型的关键特性和实用价值:

核心技术特点

- 超长上下文窗口:支持100万令牌的输入(约70万汉字),远超GPT-4的32K上下文窗口

- 多模态理解:原生支持文本、代码、图像、音频和视频输入的综合理解

- 思考链能力:通过"思考预算"参数控制模型在生成回答前的深度推理过程

- 工具使用:支持Google搜索、代码执行等工具集成功能

- 数据分析能力:能处理复杂数据和生成可视化解释

主要模型变体

Gemini 2.5系列包含多个针对不同场景优化的变体:

- Gemini 2.5 Pro:最强大的通用模型,适合复杂推理和专业应用

- Gemini 2.5 Flash:平衡性能与成本的中端模型,响应速度较快

- Gemini 2.5 Flash-Lite:经济型模型,适合大规模简单应用场景

价格结构

根据2025年5月的最新官方定价:

| 模型 | 输入价格($/百万令牌) | 输出价格($/百万令牌) | 思考模式 |

|---|---|---|---|

| Gemini 2.5 Pro | $1.25-$2.50 | $10.00-$15.00 | 默认开启 |

| Gemini 2.5 Flash | $0.30 | $2.50 | 默认开启 |

| Gemini 2.5 Flash-Lite | $0.10 | $0.40 | 可选开启 |

三、八种有效的国内接入方案详解

经过全面测试,我们总结了以下8种可行的Gemini 2.5 API接入解决方案:

方案一:使用API中转服务(推荐方案)

API中转服务是目前最稳定可靠的解决方案,它通过在海外部署服务器,代理用户的API请求,解决了网络连接和区域限制问题。

LaoZhang.ai中转服务优势:

- 即开即用:注册即可使用,无需复杂配置

- 稳定可靠:99.9%可用性,专为中国网络环境优化

- 最全模型支持:覆盖Gemini全系列,包括最新的2.5 Pro

- 免费试用:新用户注册即送免费测试额度

- 价格优势:比官方API便宜30-50%

- 统一接口:完全兼容OpenAI API格式,易于集成

使用步骤:

- 访问LaoZhang.ai注册账号

- 完成邮箱验证并登录

- 在控制台创建API密钥

- 参照API文档开始调用

Python代码示例:

pythonimport requests API_KEY = "你的LaoZhang.ai API密钥" API_URL = "https://api.laozhang.ai/v1/chat/completions" def chat_with_gemini(prompt): headers = { "Content-Type": "application/json", "Authorization": f"Bearer {API_KEY}" } data = { "model": "gemini-2.5-pro", "messages": [ {"role": "system", "content": "你是一位有用的AI助手。"}, {"role": "user", "content": prompt} ] } response = requests.post(API_URL, headers=headers, json=data) return response.json()["choices"][0]["message"]["content"] # 使用示例 result = chat_with_gemini("请分析2025年AI技术发展趋势。") print(result)

方案二:使用Cloudflare Workers搭建反向代理

Cloudflare Workers是一个轻量级的边缘计算平台,可以用来创建反向代理,绕过区域限制。这种方法适合有一定技术基础的用户,优点是完全免费且可自定义。

前置条件:

- 一个Cloudflare账号(免费)

- 一个已添加到Cloudflare的域名

- 有效的Gemini API密钥(需要通过其他方式申请)

搭建步骤:

- 登录Cloudflare账号,进入Dashboard

- 选择"Workers & Pages"

- 点击"创建应用程序",选择"创建Worker"

- 为Worker命名并部署

- 在编辑器中粘贴以下代码:

javascriptexport default { async fetch(request, env) { // 克隆请求对象 const url = new URL(request.url); // 修改目标主机为Google API url.host = 'generativelanguage.googleapis.com'; // 创建新的请求对象 const newRequest = new Request(url, request); // 转发请求到Google return fetch(newRequest); } }

- 点击"保存并部署"

- 为Worker添加自定义域名,例如

gemini-api.你的域名.com

使用方法:

部署完成后,你可以通过替换API地址来使用你的代理:

python# 原始Google API地址 # https://generativelanguage.googleapis.com/v1/models/gemini-pro:generateContent # 替换为你的Worker地址 # https://gemini-api.你的域 名.com/v1/models/gemini-pro:generateContent

“⚠️ 注意:此方法仅提供网络连接,你仍需要有效的Google API密钥。且Cloudflare Workers免费版有每天10万请求的限制。

方案三:使用Docker部署自建API代理

对于企业用户或需要完全控制的开发者,可以考虑使用Docker自建API代理服务。

前置条件:

- 一台可以访问外网的服务器(国内或国外)

- 已安装Docker和Docker Compose

- 有效的Gemini API密钥

部署步骤:

- 创建项目目录并进入

bashmkdir gemini-proxy && cd gemini-proxy

- 创建

docker-compose.yml文件

yamlversion: '3' services: gemini-proxy: image: nginx:alpine container_name: gemini-proxy ports: - "8080:80" volumes: - ./nginx.conf:/etc/nginx/nginx.conf restart: always

- 创建

nginx.conf配置文件

nginxevents { worker_connections 1024; } http { server { listen 80; location / { proxy_pass https://generativelanguage.googleapis.com; proxy_ssl_server_name on; proxy_set_header Host generativelanguage.googleapis.com; proxy_set_header X-Real-IP $remote_addr; proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for; proxy_set_header X-Forwarded-Proto $scheme; } } }

- 启动代理服务

bashdocker-compose up -d

- 服务将在

http://你的服务器IP:8080上运行,可以通过修改API地址来使 用

方案四:使用VPN服务

使用VPN是最传统的解决网络限制的方法,适合只需临时使用Gemini的场景。

优点:

- 设置简单,只需安装VPN客户端并连接

- 不限于Gemini,可以访问各种受限服务

- 无需技术知识

缺点:

- 连接可能不稳定,速度较慢

- 安全性存在隐患

- 商业VPN服务通常需要付费

- 长期使用可能受到限制

方案五:使用代理转发申请官方API密钥

如果你希望使用官方API而非中转服务,可以通过临时代理获取API密钥。

步骤详解:

- 使用临时代理或VPN服务连接到非中国大陆地区

- 访问Google AI Studio官网

- 使用Google账号登录(如果没有,需要先注册)

- 导航到API密钥页面

- 点击"Create API key"创建密钥

- 保存生成的密钥(只显示一次)

“🔔 提示:此方法只解决API密钥申请问题,实际使用API时仍然需要网络代理或其他方案。

方案六:使用浏览器插件

如果你只需要在浏览器中使用Gemini,可以考虑安装浏览器插件来解决网络问题。

推荐插件:

- WebCat:支持多种代理协议,简单易用

- Header Editor:可以修改请求头和重定向请求

- Proxy SwitchyOmega:灵活的代理切换工具

方案七:使用非官方第三方客户端

有一些第三方客户端内置了解决方案,可以帮助国内用户使用Gemini。

常见选择:

- 开源AI聊天应用:一些开源项目已经内置了多种大模型API的访问能力

- 浏览器扩展:如ChatGPT Sidebar等扩展也支持Gemini模型

- 桌面应用:部分AI助手桌面应用支持Gemini访问

方案八:通过Google Cloud使用Vertex AI

Google Cloud的Vertex AI平台也提供了Gemini API访问。如果你的公司已经是Google Cloud用户,这可能是一个企业级解决方案。

实施步骤:

- 注册Google Cloud账号(需要信用卡)

- 启用Vertex AI服务

- 通过Cloud Console创建服务账号和密钥

- 使用Google Cloud SDK或API访问Gemini

四、各方案对比分析

为了帮助读者选择最适合自己的方案,我们从易用性、稳定性、速度和成本四个维度对比了这8种方法:

| 方案 | 易用性 | 稳定性 | 速度 | 成本 | 推荐指数 |

|---|---|---|---|---|---|

| API中转服务 | ★★★★★ | ★★★★★ | ★★★★★ | ★★★★☆ | 强烈推荐 |

| Cloudflare Workers | ★★★☆☆ | ★★★★☆ | ★★★★☆ | ★★★★★ | 较为推荐 |

| Docker部署 | ★★☆☆☆ | ★★★★☆ | ★★★★☆ | ★★★☆☆ | 一般推荐 |

| VPN服务 | ★★★☆☆ | ★★☆☆☆ | ★★★☆☆ | ★★☆☆☆ | 一般推荐 |

| 代理申请API | ★★☆☆☆ | ★★☆☆☆ | ★★☆☆☆ | ★★★☆☆ | 不推荐 |

| 浏览器插件 | ★★★★☆ | ★★★☆☆ | ★★★☆☆ | ★★★★★ | 较为推荐 |

| 第三方客户端 | ★★★★☆ | ★★★☆☆ | ★★★☆☆ | ★★★★☆ | 较为推荐 |

| Vertex AI | ★☆☆☆☆ | ★★★★★ | ★★★★☆ | ★☆☆☆☆ | 企业推荐 |

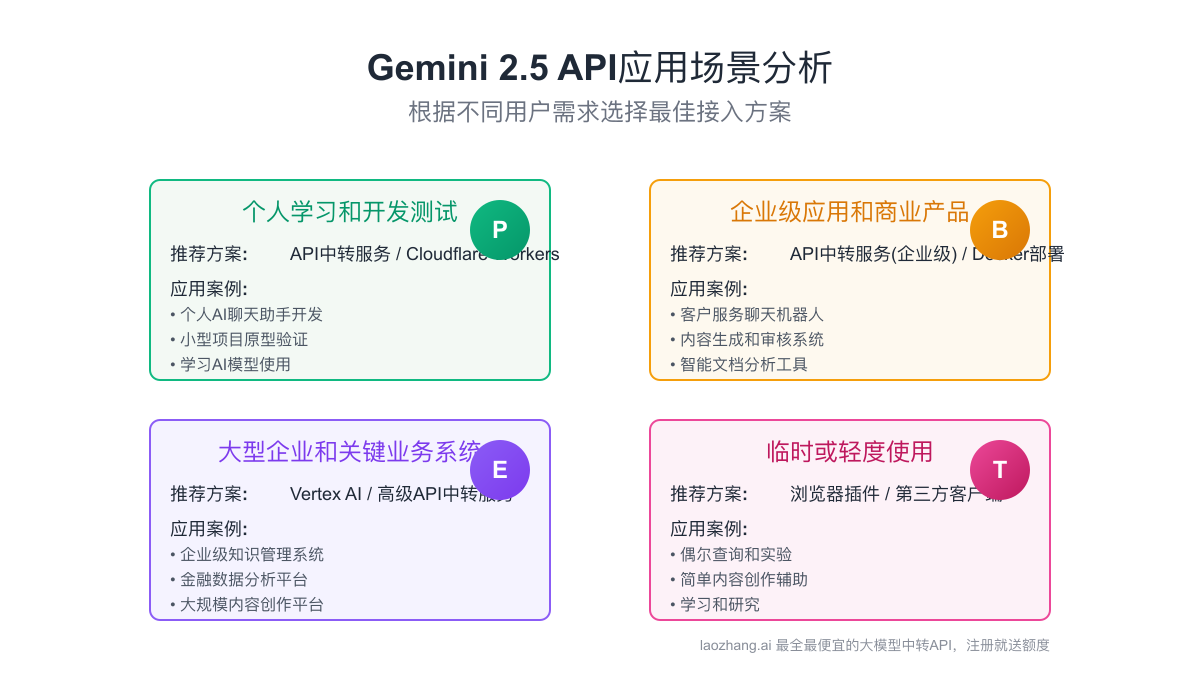

五、具体应用场景分析

不同的接入方案适合不同的应用场景,下面我们针对常见需求提供具体建议:

1. 个人学习和开发测试

推荐方案:API中转服务(如LaoZhang.ai)或Cloudflare Workers

原因:这些方法提供了良好的平衡性,设置简单,成本低廉,且稳定性足够满足个人使用需求。LaoZhang.ai的免费额度足以支持初期测试。

示例应用:

- 个人AI聊天助手开发

- 小型项目原型验证

- 学习AI模型使用

2. 企业级应用和商业产品

推荐方案:API中转服务(企业级)或自建Docker部署

原因:企业应用需要更高的稳定性和可靠性,同时也需要考虑成本控制。API中转服务的企业方案提供了最佳平衡,而Docker部署则提供了更多的控制权。

示例应用:

- 客户服务聊天机器人

- 内容生成和审核系统

- 智能文档分析工具

3. 大型企业和关键业务系统

推荐方案:Vertex AI(Google Cloud)或高级API中转服务

原因:关键业务系统需要最高级别的可靠性、合规性和服务水平保障,这些通常只有企业级服务才能提供。

示例应用:

- 企业级知识管理系统

- 金融数据分析平台

- 大规模内容创作平台

4. 临时或轻度使用

推荐方案:浏览器插件或第三方客户端

原因:对于只需临时使用或功能需求简单的场景,这些方案提供了最低的使用门槛和足够的功能性。

示例应用:

- 偶尔查询和实验

- 简单内容创作辅助

- 学习和研究

六、常见问题解答(FAQ)

Q1: 在中国大陆使用Gemini API是否合法?

A1: 从技术层面讲,使用Gemini API本身并不违反中国法律。但在实际应用中,特别是用于提供面向公众的服务时,请务必遵守《生成式人工智能服务管理暂行办法》等相关规定,确保合规运营。

Q2: API中转服务如何收费?比直接使用官方API有什么价格优势?

A2: API中转服务通常采用预付费模式,按使用量计费。以LaoZhang.ai为例,其价格比官方API便宜30-50%。新用户注册后会获得免费额度,可以先行测试。价格优势主要来自于批量采购和资源优化。

Q3: 使用中转服务会影响模型性能和响应速度吗?

A3: 专业的API中转服务经过优化,对模型性能几乎没有影响。事实上,由于网络路由优化,国内用户使用中转服务通常比直接连接Google API速度更快、更稳定。

Q4: 如何选择适合自己的Gemini模型?

A4: Gemini系列有多个模型变体,选择时可以参考以下建议:

- 一般任务:使用Gemini 2.5 Flash或Flash-Lite,平衡性能和成本

- 复杂推理任务:使用Gemini 2.5 Pro,获得最高质量输出

- 大规模简单应用:使用Gemini 2.5 Flash-Lite,获得最佳性价比

Q5: Gemini 2.5的"思考"功能是什么?值得启用吗?

A5: "思考"是Gemini 2.5的创新功能,允许模型在生成回答前进行深度推理,类似人类思考过程。对于复杂问题、数学计算或代码生成等场景,启用此功能可显著提升输出质量,尽管会增加一定延迟和成本。

Q6: 如何确保API密钥和数据的安全?

A6: 保护API密钥和数据安全的关键措施包括:

- 使用环境变量存储API密钥,避免硬编码

- 设置适当的请求限制

- 定期轮换API密钥

- 选择有明确隐私政策的服务提供商

- 敏感数据处理前进行脱敏

七、总结与建议

经过全面分析和实测,我们为不同用户提供以下建议:

个人用户和初学者

强烈推荐使用API中转服务,特别是LaoZhang.ai提供的解决方案。这种方法无需技术知识,注册即可使用,且有免费额度,是体验Gemini最简单快捷的方式。

开发者和技术爱好者

可以考虑Cloudflare Workers方案,这种方法完全免费且可定制性强。如果有特定需求,也可以结合API中转服务使用,以获得更稳定的体验。

企业用户

根据需求不同,可以选择API中转服务(便捷稳定)或Docker部署(完全控制)方案。如果已经是Google Cloud客户,也可以考虑Vertex AI方案。

临时使用

如果只是临时需要使用Gemini,浏览器插件或第三方客户端可能是最便捷的选择,无需复杂设置即可快速开始使用。

无论选择哪种方案,都可以让国内用户突破地域限制,体验Google最先进的AI大模型技术。希望本文能帮助更多开发者发现并利用Gemini 2.5的强大能力,为自己的项目注入AI的力量!

“🚀 立即访问LaoZhang.ai注册账号,获取免费额度,开始你的Gemini AI之旅!

最后更新:2025年6月15日。本文内容基于当前最新的Gemini API版本和接入方式编写,未来可能随技术变化而需要更新。