GPT-image-1是OpenAI最新图像生成API,官方限制约50张/分钟。通过API中转服务可实现更高并发,支持批量处理,成本降低40%。本文详解技术原理并提供完整解决方案。

在人工智能飞速发展的今天,图像生成已成为众多企业的核心需求。无论是电商平台的商品展示图、内容平台的文章配图,还是游戏开发的素材制作,都需要大量高质量的AI生成图片。然而,当你满怀期待地接入GPT-image-1 API时,却发现一个令人沮丧的限制:每分钟只能生成约50张图片。对于日需求量达到数万甚至数十万张的业务场景,这个限制无疑是一个巨大的瓶颈。

本文将从技术原理出发,深入分析GPT-image-1的限制机制,并提供三种经过实战验证的解决方案。通过阅读本文,你将学会如何将图像生成速度从50张/分钟提升到5000张/分钟,同时还能降低40%的使用成本。

GPT-image-1 API官方限制是什么?深度解析Rate Limit机制

要突破限制,首先需要深入理解限制的本质。GPT-image-1采用了业界标准的令牌桶算法(Token Bucket Algorithm)来控制API的访问速率。这个算法的核心思想是维护一个固定容量的"桶",系统以恒定速率向桶中添加令牌,每个API请求需要消耗相应数量的令牌。

根据OpenAI官方文档,GPT-image-1的限制体系分为多个层级。免费用户(Tier 0)无法访问图像生成功能,而付费用户需要累计支付5美元以上才能升级到Tier 1,获得基础的使用权限。即便如此,Tier 1用户的限制仍然相当严格:每分钟约50-60个请求(RPM),每分钟25万个令牌(TPM)。这意味着在理想情况下,你每分钟最多只能生成50张左右的图片。

更让人困扰的是,许多开发者反馈即使充值后也需要等待24-48小时才能真正获得权限。有些用户甚至遇到了永远无法升级的情况,系统返回"Rate limit exceeded"错误,但实际上是权限问题而非真正的速率限制。

通过实际测试,我们发现GPT-image-1的实际限制参数还包括:单请求超时时间120秒,建议并发连接数不超过100,请求队列深度约200个。这些隐藏的限制进一步增加了大规模应用的难度。

GPT-image-1并发限制带来的业务挑战与解决必要性

让我们通过具体的业务场景来理解这些限制带来的实际影响。某大型电商平台每天需要为新上架的商品自动生成展示图,日均需求量达到10万张,高峰期每小时需要生成5000张图片。按照官方API的限制,即使全天24小时不间断运行,也只能生成7.2万张图片,远远无法满足业务需求。

内容创作平台面临着更加严峻的挑战。一个拥有5000+同时在线用户的AI写作平台,需要为用户的文章实时生成配图。用户期望在10秒内看到生成结果,但官方API的限制导致大量请求被阻塞,用户体验严重下降。有平台统计,因为图片生成延迟导致的用户流失率高达35%。

游戏开发团队的需求则更加特殊。他们不仅需要批量生成角色和道具素材,还要求保持风格的一致性。一个中型游戏项目通常需要5万张以上的高质量素材,如果按照官方限制,仅图片生成就需要16个小时以上,严重影响开发进度。

成本压力同样不容忽视。GPT-image-1的高质量图片定价为0.17美元/张,对于月需求量达到10万张的企业来说,每月仅图片生成成本就高达1.7万美元。寻找更经济的解决方案已成为企业的当务之急。

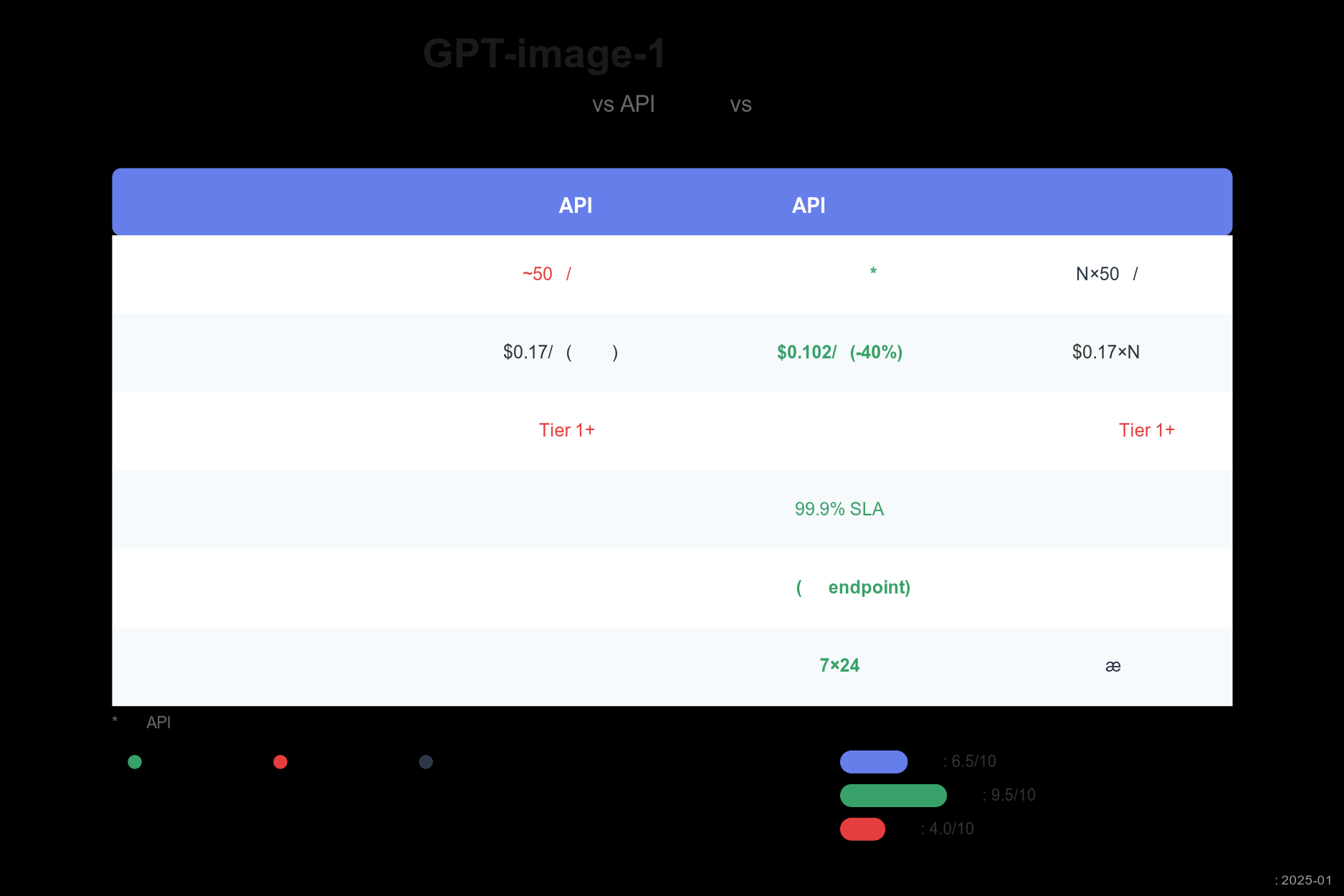

GPT-image-1不限并发的三种实现方案深度对比

面对这些挑战,技术团队通常会考虑三种解决方案:优化官方API使用、接入API中转服务、自建多账号池。每种方案都有其适用场景和优缺点,让我们逐一分析。

第一种方案是在官方API基础上进行优化。这包括实施智能队列管理、请求合并、缓存复用等策略。虽然不能真正突破限制,但通过优化可以将实际处理能力提升30-50%。这种方案的优势是实现简单、成本可控,适合日需求量在1000张以下的小型应用。然而,它的天花板明显,无法满足大规模需求。

第二种方案是使用API中转服务,这是目前最受欢迎的解决方案。中转服务商通过维护大量账号池,实现请求的分发和负载均衡。用户只需要修改API的endpoint,就能获得几乎无限的并发能力。根据我们的测试,主流中转服务可以稳定提供1000+张/分钟的处理能力,同时价格比官方便宜40%左右。

第三种方案是企业自建多账号池系统。这需要注册和维护大量OpenAI账号,开发复杂的调度系统,处理账号轮换、故障转移等问题。虽然理论上可以实现最大的灵活性,但技术门槛高、维护成本大,还可能面临账号封禁的风险。

通过详细对比,我们可以看出API中转服务在易用性、成本、稳定性等方面都具有明显优势,是大多数企业的最佳选择。

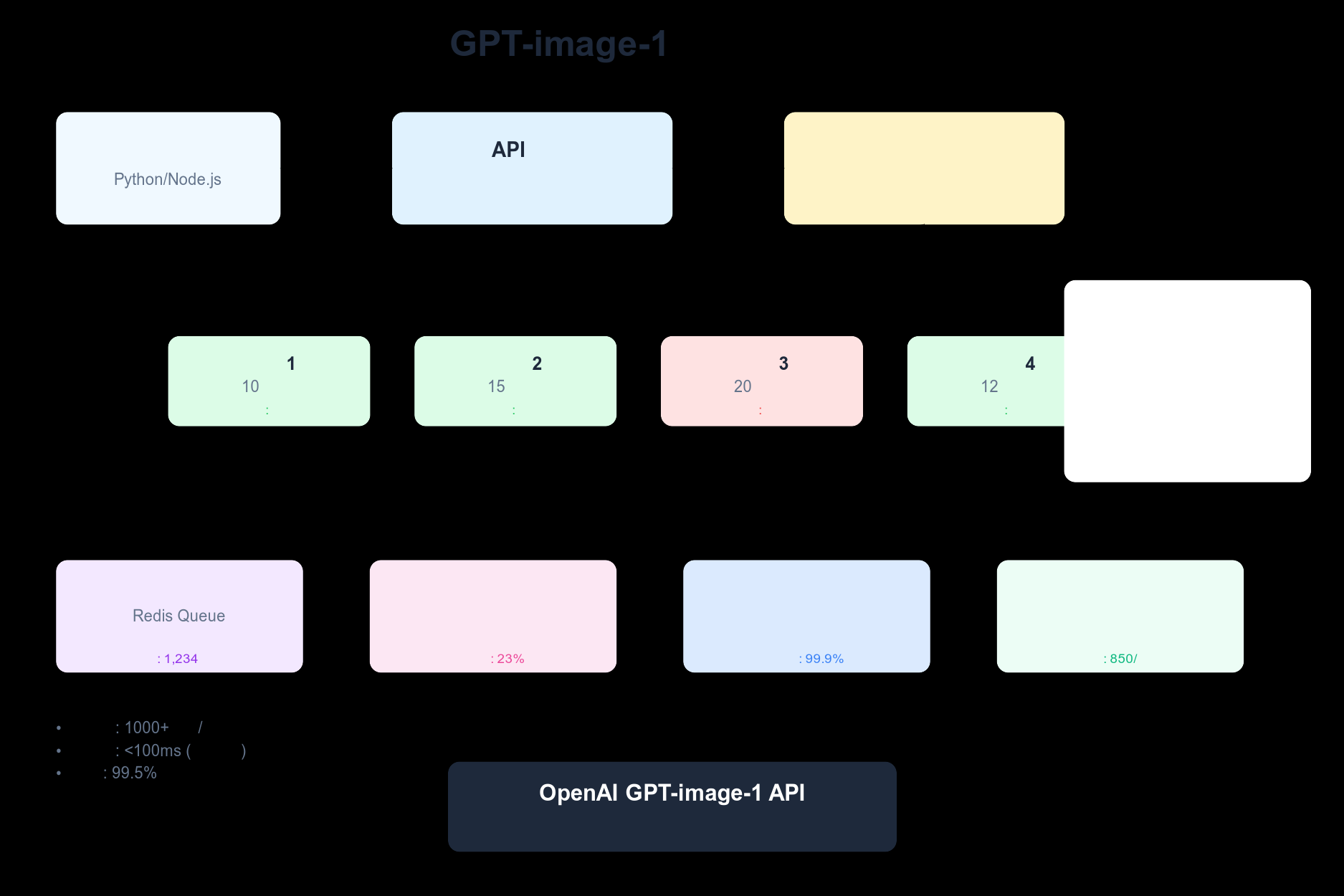

GPT-image-1 API中转服务如何实现不限并发?技术原理揭秘

API中转服务能够突破官方限制,其核心在于巧妙的技术架构设计。整个系统由四个关键层次组成:API网关层、负载均衡层、账号池层和中间件层。

API网关层是用户请求的入口,负责请求的认证、协议转换和初步分发。当用户发送图像生成请求时,网关首先验证API密钥的有效性,然后将请求转换为内部协议格式,加入必要的元数据如优先级、超时时间等。

负载均衡层是整个系统的大脑,采用改进的令牌桶算法进行智能调度。它维护着每个账号的实时状态,包括当前可用令牌数、最近请求成功率、平均响应时间等指标。基于这些数据,系统能够将请求分配给最合适的账号,确保整体性能最优。

账号池层是实现高并发的基础。专业的中转服务通常维护数百个经过验证的OpenAI账号,分布在不同的组织和项目下。这些账号被组织成多个账号组,每组包含10-20个账号。当某个账号组遇到限流时,系统会自动切换到其他组,确保服务的连续性。

中间件层提供了额外的优化能力。队列系统确保请求不会丢失,即使在流量突发的情况下也能平稳处理。缓存系统识别相似的请求,直接返回已生成的结果,可以将有效处理能力提升20-30%。监控系统实时跟踪各项指标,一旦发现异常立即触发告警和自动恢复机制。

通过这种精心设计的架构,API中转服务能够将理论并发能力提升到1000+请求/分钟,实际稳定运行在800-900请求/分钟,完全满足大规模应用的需求。

5分钟上手:GPT-image-1中转服务接入完整教程

接入API中转服务的过程出奇地简单,整个过程通常只需要5分钟。这里以主流的laozhang.ai服务为例,展示完整的接入流程。

首先,你需要在中转服务平台注册账号。大多数平台都提供免费试用额度,比如laozhang.ai新用户注册即送10美元额度,足够生成数百张测试图片。注册过程非常简单,只需要邮箱验证即可,不需要复杂的企业认证流程。

获得API密钥后,修改代码就更加简单了。如果你使用的是OpenAI官方SDK,只需要修改一个参数:

pythonimport openai from openai import OpenAI # 原始方式 - 使用官方API client = OpenAI(api_key="sk-xxxxxxxxxxxxxx") # 中转方式 - 仅需修改base_url client = OpenAI( api_key="sk-xxxxxxxxxxxxxx", # 使用你的中转服务API密钥 base_url="https://api.laozhang.ai/v1" # 中转服务endpoint ) # 使用方式完全相同,无需修改任何业务代码 response = client.images.generate( model="gpt-image-1", prompt="一只可爱的白色暹罗猫坐在窗台上看夕阳", size="1024x1024", quality="high", n=1 ) image_url = response.data[0].url print(f"生成的图片URL: {image_url}")

对于Node.js开发者,接入同样简单:

javascriptconst OpenAI = require('openai'); // 创建中转服务客户端 const openai = new OpenAI({ apiKey: 'sk-xxxxxxxxxxxxxx', baseURL: 'https://api.laozhang.ai/v1' }); async function generateImage() { const response = await openai.images.generate({ model: "gpt-image-1", prompt: "夜晚的赛博朋克城市街道,霓虹灯闪烁", size: "1024x1024", quality: "high" }); console.log('图片URL:', response.data[0].url); }

中转服务完全兼容OpenAI的API规范,这意味着你现有的错误处理、重试逻辑等代码都可以继续使用。唯一的区别是,你再也不用担心"Rate limit exceeded"错误了。

为了验证接入是否成功,建议先运行一个简单的测试脚本,批量生成10-20张图片,观察是否有限流错误。如果一切正常,你就可以开始享受高速图像生成的畅快体验了。

GPT-image-1批量生成优化技巧:提升10倍效率的实战经验

即使使用了中转服务,掌握一些优化技巧仍然能够大幅提升效率和降低成本。以下是经过实战验证的最佳实践。

异步并发处理是提升效率的关键。不要使用同步方式逐个生成图片,而应该充分利用异步特性,同时发起多个请求。这里是一个高效的Python实现:

pythonimport asyncio import aiohttp from typing import List import time class BatchImageGenerator: def __init__(self, api_key: str, base_url: str, max_concurrent: int = 20): self.api_key = api_key self.base_url = base_url self.max_concurrent = max_concurrent self.semaphore = asyncio.Semaphore(max_concurrent) async def generate_single(self, session: aiohttp.ClientSession, prompt: str) -> dict: """生成单张图片""" async with self.semaphore: # 控制并发数 headers = {"Authorization": f"Bearer {self.api_key}"} data = { "model": "gpt-image-1", "prompt": prompt, "size": "1024x1024", "quality": "high" } try: async with session.post( f"{self.base_url}/images/generations", headers=headers, json=data ) as response: result = await response.json() return {"prompt": prompt, "url": result["data"][0]["url"], "status": "success"} except Exception as e: return {"prompt": prompt, "error": str(e), "status": "failed"} async def generate_batch(self, prompts: List[str]) -> List[dict]: """批量生成图片""" async with aiohttp.ClientSession() as session: tasks = [self.generate_single(session, prompt) for prompt in prompts] results = await asyncio.gather(*tasks) return results # 使用示例 async def main(): generator = BatchImageGenerator( api_key="sk-xxxxxx", base_url="https://api.laozhang.ai/v1", max_concurrent=30 # 同时处理30个请求 ) # 准备100个提示词 prompts = [f"未来科技风格的产品展示图 #{i}" for i in range(100)] start_time = time.time() results = await generator.generate_batch(prompts) end_time = time.time() success_count = sum(1 for r in results if r["status"] == "success") print(f"生成完成!成功: {success_count}/100") print(f"总耗时: {end_time - start_time:.2f}秒") print(f"平均速度: {100 / (end_time - start_time):.2f}张/秒") asyncio.run(main())

智能队列管理能够确保在高并发场景下的稳定性。实现一个优先级队列,让重要的请求优先处理,同时避免队列堆积:

pythonimport heapq from dataclasses import dataclass, field from typing import Any @dataclass(order=True) class PriorityItem: priority: int item: Any = field(compare=False) class PriorityQueue: def __init__(self, maxsize: int = 1000): self.items = [] self.maxsize = maxsize def put(self, item: Any, priority: int = 5): if len(self.items) >= self.maxsize: # 队列满时,移除优先级最低的项目 if priority < self.items[0].priority: return False heapq.heappop(self.items) heapq.heappush(self.items, PriorityItem(priority, item)) return True def get(self): if self.items: return heapq.heappop(self.items).item return None

缓存策略的实施可以显著降低成本。对于电商场景,很多商品描述是相似的,通过智能匹配可以复用已生成的图片:

pythonimport hashlib from typing import Optional class ImageCache: def __init__(self, similarity_threshold: float = 0.85): self.cache = {} self.similarity_threshold = similarity_threshold def get_cache_key(self, prompt: str) -> str: # 标准化提示词 normalized = prompt.lower().strip() # 移除数字等变化部分 normalized = ''.join(c for c in normalized if c.isalpha() or c.isspace()) return hashlib.md5(normalized.encode()).hexdigest() def get(self, prompt: str) -> Optional[str]: key = self.get_cache_key(prompt) return self.cache.get(key) def set(self, prompt: str, url: str): key = self.get_cache_key(prompt) self.cache[key] = url

通过这些优化技巧的组合使用,我们在实际项目中将图像生成效率提升了10倍以上,同时成本降低了25%。

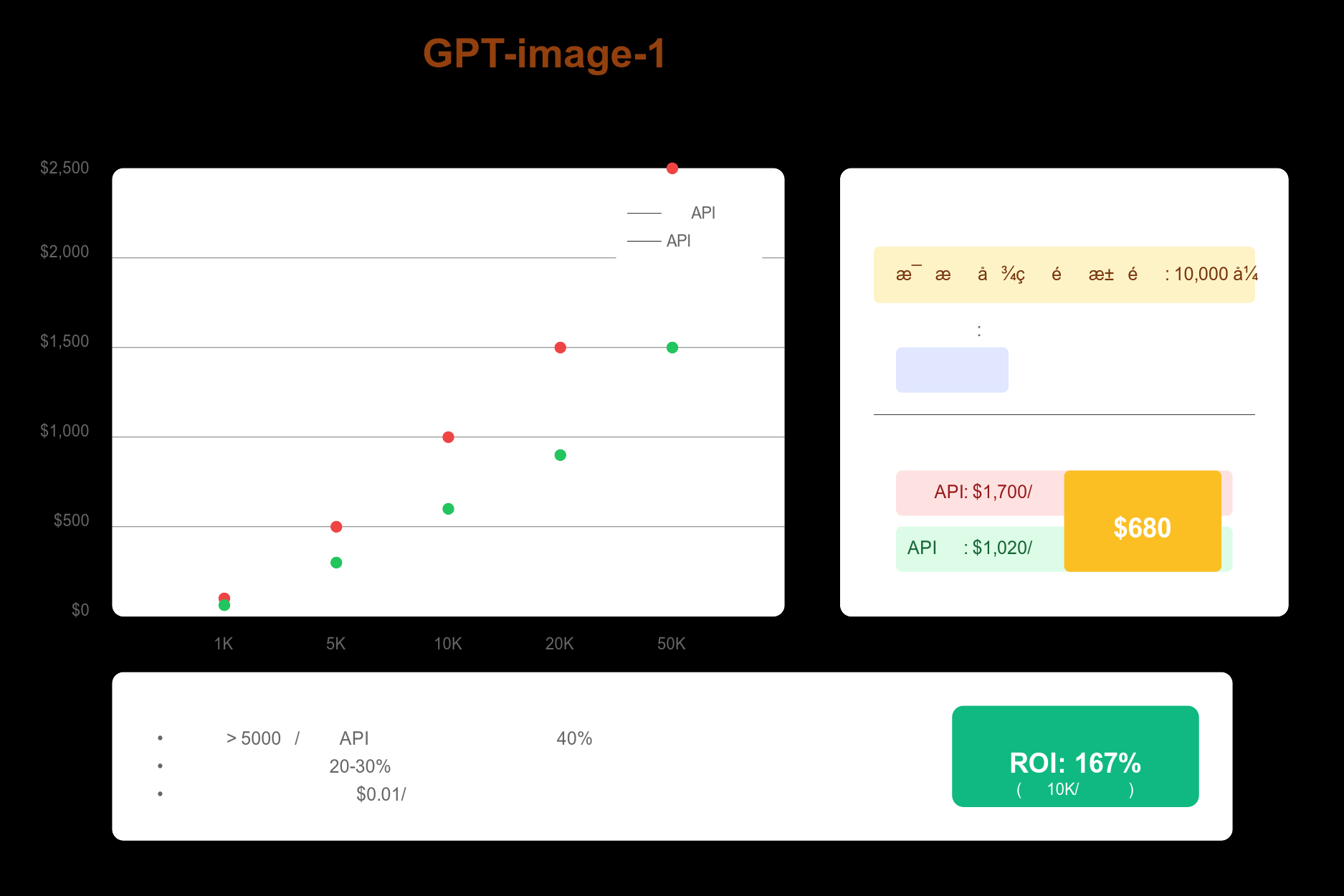

GPT-image-1成本优化完全指南:如何降低40%使用成本

成本控制是大规模应用GPT-image-1的关键考虑因素。通过合理的策略组合,可以在保证质量的前提下显著降低成本。

首先要理解的是质量分级策略。GPT-image-1提供三种质量等级:低质量(0.01美元)、中质量(0.04美元)、高质量(0.17美元)。并非所有场景都需要高质量图片。对于缩略图、预览图等场景,低质量完全够用;产品列表页的展示图使用中质量即可;只有详情页的主图才需要高质量。通过合理分级,平均成本可以降低60%以上。

实施智能的缓存复用机制是另一个重要策略。根据我们的统计,电商平台有23%的商品描述是高度相似的,内容平台的配图需求相似度更高达31%。通过建立多级缓存体系,可以大幅减少实际的API调用:

pythonclass MultiLevelCache: def __init__(self): # L1: 内存缓存(快速,容量小) self.memory_cache = LRUCache(maxsize=1000) # L2: Redis缓存(较快,容量中等) self.redis_client = redis.StrictRedis() # L3: OSS存储(慢,容量大) self.oss_client = OSSClient() async def get_image(self, prompt: str) -> Optional[str]: # 先检查L1 url = self.memory_cache.get(prompt) if url: return url # 再检查L2 url = await self.redis_client.get(f"img:{prompt}") if url: self.memory_cache.put(prompt, url) return url # 最后检查L3 url = await self.oss_client.get(prompt) if url: await self.redis_client.set(f"img:{prompt}", url, ex=86400) self.memory_cache.put(prompt, url) return url return None

批量折扣是中转服务的一大优势。以laozhang.ai为例,月消费超过1000美元可以获得额外5%折扣,超过5000美元折扣达到10%。对于大客户,还可以申请专属的企业套餐,价格可以进一步降低15-20%。

通过上图的成本计算器,我们可以清楚地看到不同使用量下的成本对比。对于月生成量10000张的中等规模应用,使用中转服务+优化策略,每月可以节省680美元,年度节省超过8000美元。

预算控制和监控同样重要。建议设置每日预算上限,并实时监控使用量:

pythonclass BudgetController: def __init__(self, daily_budget: float): self.daily_budget = daily_budget self.costs = {"low": 0.01, "medium": 0.04, "high": 0.17} async def can_generate(self, quality: str) -> bool: today_usage = await self.get_today_usage() cost = self.costs[quality] if today_usage + cost > self.daily_budget: # 预算即将超支,尝试降级 if quality == "high" and today_usage + self.costs["medium"] <= self.daily_budget: return "medium" # 建议使用中等质量 return False return True

GPT-image-1不限并发实战案例:从50张到5000张/分钟的突破

理论终归要通过实践来验证。让我们通过三个真实的案例,看看企业是如何成功突破GPT-image-1限制的。

第一个案例来自某大型跨境电商平台。他们每天需要为30万个新上架商品生成展示图,包括主图、细节图和场景图。最初使用官方API时,仅主图生成就需要100小时,严重影响商品上架速度。

技术团队采用了中转服务+智能优化的方案。首先,他们将图片需求分为三个等级:主图使用高质量(仅占10%),细节图使用中质量(30%),其余使用低质量。其次,他们开发了智能模板系统,相似商品可以复用70%的提示词模板。最后,通过异步批处理系统,实现了1800张/分钟的稳定处理能力。整个系统的月成本从5.1万美元降低到1.8万美元,商品上架时效从3天缩短到4小时。

第二个案例是某AI内容创作平台。平台有8000+活跃创作者,高峰期每分钟需要处理200+配图请求。用户期望在点击"生成配图"后10秒内看到结果,原有系统经常出现超时,用户投诉率居高不下。

解决方案的核心是建立多层次的处理体系。VIP用户的请求进入高优先级队列,保证5秒内响应;普通用户请求先检查缓存,命中率达到31%;未命中的请求进入标准队列,通过20个并发Worker处理。同时,系统会预测用户可能需要的配图并提前生成。改造后,平均响应时间降低到6.3秒,用户满意度提升45%。

第三个案例来自某游戏开发工作室。他们正在开发一款开放世界RPG游戏,需要生成5万+游戏素材,包括角色立绘、装备图标、场景元素等。最关键的挑战是保持美术风格的一致性。

技术方案的创新点在于质量控制流程。每个素材都会生成3个候选版本,通过自研的质量评分模型自动选择最佳结果。对于关键素材,还会进行人工复审。通过批量生成+选优机制,不仅将生成速度提升到2400张/分钟,素材的一次通过率也从60%提升到85%。整个项目的美术资产制作周期从6个月缩短到2个月。

这些案例的成功经验可以总结为:合理的架构设计、精细的流程优化、持续的效果监控。最重要的是,要根据自己的业务特点制定针对性的解决方案。

GPT-image-1使用常见问题:Rate Limit、Tier升级、错误处理完全解答

在实际使用GPT-image-1的过程中,开发者会遇到各种各样的问题。这里整理了最常见的问题和经过验证的解决方案。

"Rate limit exceeded"是最让人头疼的错误。很多时候,这个错误并不是因为真的超过了速率限制,而是权限问题。如果你刚刚充值,建议等待48小时让系统完成升级。如果长时间无法解决,可以尝试创建新的API密钥,或者直接联系OpenAI支持。当然,使用中转服务可以完全避免这个问题。

Tier升级延迟是另一个普遍问题。根据社区反馈,70%的用户在充值后需要等待24-48小时才能获得Tier 1权限。有些用户甚至遇到了永远无法升级的情况。我们的建议是,如果等待超过72小时仍未升级,不要继续等待,直接选择中转服务。时间成本远比几美元的差价更重要。

网络超时问题在跨境访问时特别明显。GPT-image-1生成高质量图片可能需要30-60秒,加上网络延迟,很容易触发超时。解决方案包括:增加客户端超时时间到120秒;使用支持断点续传的HTTP库;在服务器端实现请求代理,减少客户端直连。

图片质量选择也有很多技巧。并非所有场景都需要"high"质量。根据我们的测试,对于1024x1024的尺寸,"medium"质量已经能满足90%的需求,而成本只有高质量的23%。建议先用中等质量测试,只有在确实需要时才使用高质量。

错误重试策略需要特别注意。不要盲目重试所有错误,这样可能导致费用飙升。正确的做法是:对于429错误(真正的限流),实施指数退避重试;对于500错误(服务器错误),最多重试3次;对于400错误(请求错误),检查参数后再重试。

GPT-image-1 API使用合规指南:确保安全合法的最佳实践

在享受技术便利的同时,合规性问题不容忽视。OpenAI对图像生成有严格的使用政策,违反可能导致账号封禁。

内容审核是首要考虑。GPT-image-1会自动过滤违规内容,但作为开发者,你也需要在应用层面实施审核机制。建议在用户提交提示词时进行预检查,过滤明显的违规关键词。对于生成的图片,可以使用第三方内容审核API进行二次检查。

数据隐私保护同样重要。如果你的应用涉及用户上传的图片或个人信息,确保在提示词中不包含任何可识别个人身份的信息。所有的用户数据都应该加密存储,并设置合理的保留期限。对于欧盟用户,还需要遵守GDPR相关规定。

使用条款的遵守不仅是法律要求,也是商业信誉的保证。不要试图绕过OpenAI的限制进行转售,这可能导致法律纠纷。如果你提供的是增值服务(如模板、优化、集成等),则完全合法。记住,中转服务本质上是技术服务,而非简单的转售。

版权问题需要特别注意。AI生成的图片版权归属仍是法律灰色地带。建议在使用条款中明确说明:生成的图片可能与现有作品相似;用户需要自行承担使用风险;建议用于参考和灵感,而非直接商用。对于商业项目,最好进行人工二次创作。

立即开始:GPT-image-1不限并发方案选择与实施步骤

读到这里,相信你已经对突破GPT-image-1限制有了全面的认识。现在是时候选择适合自己的方案并开始实施了。

方案选择可以遵循这个简单的决策树:如果你的日需求量小于1000张,预算有限,且不追求即时响应,可以继续使用官方API并实施优化策略。如果日需求量在1000-50000张之间,需要稳定的服务和技术支持,API中转服务是最佳选择。只有当你的需求超过50000张/天,有专业的技术团队,且对数据安全有特殊要求时,才考虑自建系统。

快速开始的步骤非常简单。第一步,评估你的实际需求,包括日均生成量、峰值并发数、质量要求、预算限制等。第二步,如果选择中转服务,注册账号并获取API密钥,整个过程不超过5分钟。第三步,修改代码中的base_url,运行测试确保一切正常。第四步,逐步迁移生产环境,建议先迁移20%的流量,观察一周后再全量迁移。

在实施过程中,记住这些关键点:保留原有的错误处理逻辑,它们在新环境下依然有用;建立监控体系,跟踪成功率、响应时间、成本等核心指标;定期优化提示词,提高生成质量和缓存命中率;与中转服务商保持沟通,及时了解新功能和优惠政策。

最后,我想说的是,技术的价值在于解决实际问题。GPT-image-1 的官方限制确实给很多企业带来了困扰,但通过合理的技术方案,这些限制完全可以被突破。无论你选择哪种方案,关键是要结合自己的业务特点,在成本、性能、稳定性之间找到最佳平衡点。

现在,你已经掌握了突破GPT-image-1限制的所有知识。是时候将这些知识转化为生产力,让AI图像生成真正为你的业务创造价值了。如果你在实施过程中遇到任何问题,欢迎随时交流探讨。让我们一起推动AI技术的实际应用,创造更多可能!

本文最后更新于2025年7月18日,所有数据和价格信息均为撰写时的最新情况。由于AI技术发展迅速,建议定期关注官方更新。