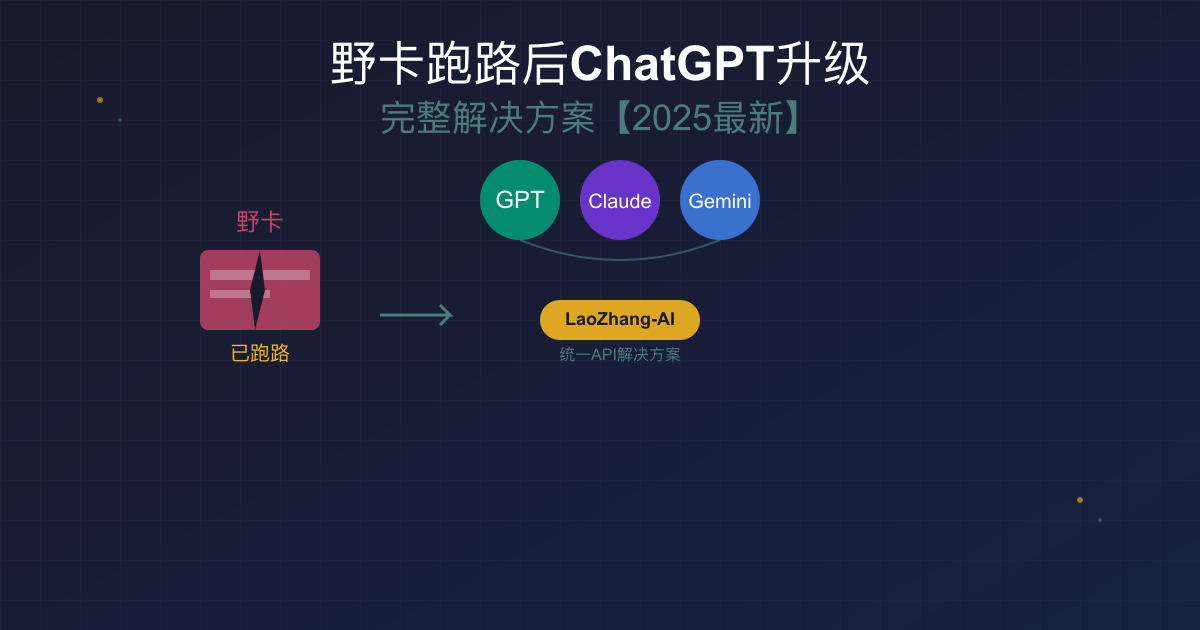

野卡(WildCard)于2025年7月12日突然停服,让众多依赖其订阅ChatGPT Plus的用户措手不及。如何在野卡跑路后继续使用ChatGPT?本文提供从紧急替代到长期解决的完整方案,帮助您快速恢复AI工具的使用。

野卡跑路事件始末与影响分析

2025年7月12日中午,WildCard官方群突然发布停服公告,声称因"不可抗力因素"立即停止全部业务。这个曾经被誉为"最方便的ChatGPT充值工具"的平台,在毫无征兆的情况下关闭,导致大量用户的预充值余额被套牢。据不完全统计,受影响用户超过10万人,涉及金额可能达到数千万元。

野卡的突然跑路不仅造成了直接的经济损失,更严重的是打断了许多用户的工作流程。开发者正在进行的项目被迫中断,内容创作者失去了重要的创作工具,研究人员的实验进度受到影响。这次事件再次提醒我们,过度依赖单一支付渠道的风险有多大。

从技术角度分析,野卡的运作模式本身就存在合规风险。通过提供美国发行的虚拟信用卡来绕过地区限制,这种灰色地带的业务模式注定难以长久。随着监管趋严,类似的虚拟卡平台可能会面临更大的生存压力。

ChatGPT Plus订阅现状:为什么这么难?

要理解为什么国内用户订阅ChatGPT Plus如此困难,我们需要了解OpenAI的支付验证机制。OpenAI使用Stripe作为支付处理商,其验证系统包含多重检查:首先是信用卡BIN码验证,只接受特定国家和地区发行的卡片;其次是IP地址匹配,要求支付时的IP地址与信用卡发行地相符;最后是AVS(地址验证系统),需要提供与信用卡关联的真实账单地址。

国内银行发行的VISA和MasterCard信用卡,即使支持外币交易,也会被OpenAI的系统识别并拒绝。这不是技术问题,而是政策限制。OpenAI明确将中国大陆列为不提供服务的地区,这种地区封锁是从支付层面实施的。即使使用香港地区的信用卡,成功率也不高,因为OpenAI对整个大中华区都采取了较为严格的限制措施。

虚拟信用卡的出现看似解决了这个问题,但实际上只是将风险转移了。这些平台通过批量申请美国或其他地区的预付卡,然后分配给用户使用。但这种模式面临着法律合规、资金安全、平台稳定性等多重风险。野卡的跑路就是最好的警示:当平台出现问题时,用户的资金安全完全没有保障。

更深层的问题是,订阅制本身对于国内用户来说并不是最优选择。每月20美元的固定费用,换来的是有限的使用额度(GPT-4每3小时80条消息),对于使用频率不固定的用户来说,这种付费模式既不灵活也不经济。

紧急替代方案一:iOS充值路径详解

对于急需恢复ChatGPT Plus使用的用户,通过iOS设备充值是目前相对可靠的方案之一。这个方法的核心是利用苹果生态系统的支付体系,绕过OpenAI的直接信用卡验证。整个流程虽然略显繁琐,但胜在稳定可靠。

第一步是注册美区Apple ID。选择注册地址时有个关键技巧:选择免税州可以避免额外的消费税。推荐选择Oregon(俄勒冈州)、Montana(蒙大拿州)、New Hampshire(新罕布什尔州)、Delaware(特拉华州)或Alaska(阿拉斯加州)。以Oregon为例,可以使用Portland的地址,邮编97201。注册时不要绑定任何支付方式,保持账户为空。

第二步是购买Apple Gift Card。可以通过淘宝、亚马逊或者一些专门的礼品卡平台购买。价格通常会有5-10%的溢价,100美元的礼品卡可能需要花费700-750元人民币。购买时要注意卖家的信誉,避免买到已经使用过的卡。收到礼品卡后,在App Store中兑换到账户余额。

第三步是下载ChatGPT应用并订阅。使用美区Apple ID登录App Store,搜索并下载ChatGPT官方应用。打开应用后,点击升级到Plus,选择月度订阅。由于是应用内购买,价格会略高于网页版,通常是22.99美元/月(因为包含了苹果税)。支付时会自动使用账户余额,无需信用卡。

这个方案的优点是稳定性高,只要苹果不改变政策,这个渠道就能持续使用。缺点是成本较高,除了ChatGPT Plus本身的费用,还要承担礼品卡溢价和苹果税,实际月成本可能达到160-180元人民币。另外,这个方法只能在iOS设备上使用,对于主要在电脑上工作的用户来说并不方便。

紧急替代方案二:其他虚拟信用卡平台评测

虽然野卡已经跑路,但市面上仍有其他虚拟信用卡平台可以尝试。需要强调的是,这些平台都存在类似的风险,使用时务必谨慎,建议采用"用多少充多少"的策略,避免大额预存。

PokePay是目前比较活跃的平台之一,支持美国和香港两种虚拟卡。美国卡可以用于ChatGPT订阅,成功率约70%。开卡费用约10美元,每月维护费3美元,充值需要使用USDT等加密货币。对于不熟悉加密货币的用户来说,门槛较高。使用时需要自己生成美国地址,推荐使用免税州地址生成器。

VCard是另一个选择,提供多种级别的虚拟卡。Advanced Lite和Platinum卡支持ChatGPT支付,但开卡费用较高,分别是50美元和100美元。优点是支持多种充值方式,包括支付宝和微信(通过第三方)。缺点是汇率不太友好,实际成本会增加15-20%。

BinPay定位更加高端,主要面向跨境电商用户。其虚拟卡质量较高,ChatGPT订阅成功率超过90%。但相应的,费用也更高:开卡费20美元,月费5美元,充值手续费3%。如果只是为了订阅ChatGPT,使用BinPay可能不太划算。

Dupay(以前叫Depay)是老牌虚拟卡平台,稳定性相对较好。提供Lite和标准两种卡,都可以用于ChatGPT订阅。月费8美元,充值手续费1.5%。需要注意的是,Dupay要求实名认证,需要提供身份证明。

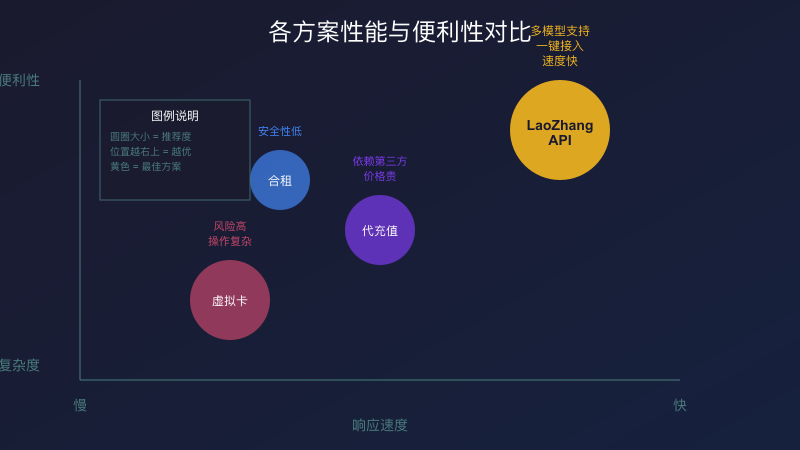

对比这些虚拟卡平台,我们可以发现它们都有共同的问题:成本高、操作复杂、存在跑路风险。算上各种费用,通过虚拟卡订阅ChatGPT Plus的实际成本可能达到200元/月以上。更重要的是,这些平台的生存状况都不稳定,野卡的今天可能就是它们的明天。

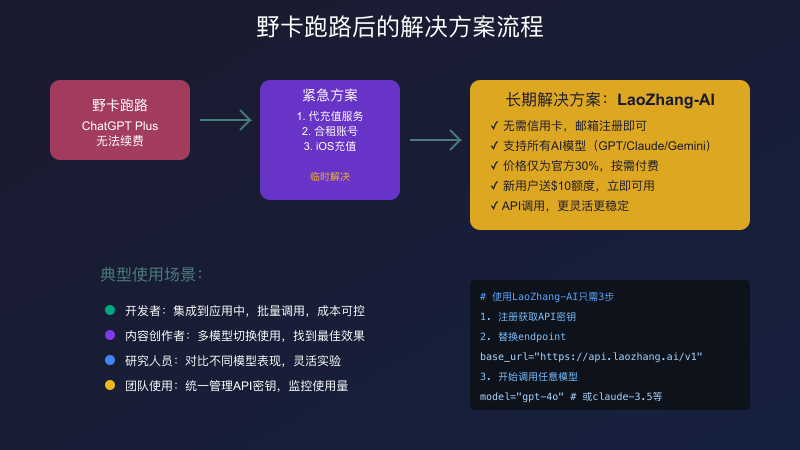

这时候,我们不禁要问:有没有更好的解决方案?与其在虚拟卡的道路上越走越远,不如换个思路。LaoZhang-AI 这样的API服务提供了一个全新的选择:不需要信用卡,不需要担心平台跑路,直接通过API调用各种AI模型,成本更低,使用更灵活。

紧急替代方案三:代充值与合租的利弊分析

代充值服务是另一种常见的解决方案。市面上有不少提供ChatGPT Plus代充值的商家,价格通常在150-180元/月。这些商家通常拥有国外信用卡或者企业账户,可以批量购买ChatGPT Plus订阅,然后转售给国内用户。

代充值的操作流程相对简单:提供你的ChatGPT账号邮箱,支付费用,等待商家完成充值。一般24小时内就能开通。部分商家还提供"永久质保"服务,承诺如果账号出现问题会免费补充。听起来很美好,但实际风险不小。

首先是账号安全风险。你需要把账号信息提供给陌生人,虽然大部分商家不需要密码,但仍然存在账号被盗用的可能。其次是服务的持续性问题。这些代充值商家同样面临支付渠道的风险,一旦他们的信用卡或支付方式出问题,你的订阅也会受到影响。最后是价格不透明,随着供需关系的变化,代充值的价格可能会大幅波动。

合租方案看似更经济,通常每人每月只需30-50元。ChatGPT Plus虽然是个人订阅,但可以在多个设备上登录使用。一些商家就利用这一点,将一个账号分享给3-5个人使用。但这种方案的问题更多。

使用合租账号意味着你的所有对话记录都可能被其他人看到,隐私完全无法保证。而且由于多人共用,很容易触发OpenAI的异常检测,导致账号被封。一旦账号出问题,维权基本无门。更麻烦的是,多人使用同一账号时,经常会出现"冲突"提示,影响使用体验。有用户反映,在关键时刻因为其他人正在使用而无法访问,严重影响了工作。

无论是代充值还是合租,本质上都是在现有限制下的妥协方案。它们解决了支付问题,但带来了新的风险。与其在这些临时方案上花费精力和金钱,不如考虑更长远的解决方案。

长期解决方案:从订阅到API的思维转变

经历了野卡跑路事件后,越来越多的用户开始意识到,依赖第三方支付渠道订阅ChatGPT Plus并不是长久之计。是时候转变思维,从订阅制转向API调用了。这不仅是支付方式的改变,更是使用模式的升级。

API(Application Programming Interface)调用看似技术门槛很高,实际上对于大多数用户来说,上手难度并不大。更重要的是,API调用带来的好处远超过学习成本。首先是成本优势,API采用按量计费,用多少付多少,避免了订阅制的浪费。对于使用量不固定的用户,可能一个月只需要花费30-50元,就能满足需求。

其次是灵活性。通过API,你可以在任何地方、任何设备上使用AI服务,不受客户端限制。可以轻松集成到自己的工作流程中,比如自动化文档处理、批量内容生成等。而且API调用没有消息数量限制,不会出现"3小时80条"这样的限制。

最大的优势是多模型支持。订阅ChatGPT Plus只能使用OpenAI的模型,但通过API,你可以自由切换使用GPT-4、Claude 3.5、Gemini Pro等多种模型。不同的模型有不同的优势,可以根据具体任务选择最合适的模型。比如,Claude在长文本处理上表现更好,Gemini在多模态理解上有优势。

安全性也是API的一大优点。你的数据直接与AI服务商通信,不经过任何第三方平台,降低了数据泄露的风险。而且API密钥可以随时更换,权限可以精确控制,安全性远高于账号密码模式。

当然,直接使用官方API也有门槛:需要国外信用卡绑定,有最低充值要求,可能面临访问限制等。这就是 LaoZhang-AI 这类API网关服务的价值所在。它们解决了支付和访问的问题,同时保留了API的所有优势,还额外提供了成本优化和多模型支持。

API调用入门:比你想象的更简单

很多人听到API就觉得很技术,需要编程基础才能使用。实际上,在2025年的今天,使用AI API已经变得非常简单。让我们通过一个具体的例子来说明。

首先,理解几个基本概念。API就是一个网址,你向这个网址发送你的问题,它返回AI的回答。Token是计费单位,大致上1000个token相当于750个英文单词或500个中文字。API Key是你的身份凭证,就像账号密码一样。

最简单的使用方式是通过在线工具。打开Postman网页版或者任何API测试工具,设置以下内容:

URL: https://api.laozhang.ai/v1/chat/completions

Method: POST

Headers:

Authorization: Bearer YOUR_API_KEY

Content-Type: application/json

Body:

{

"model": "gpt-4o",

"messages": [

{"role": "user", "content": "你好,请介绍一下自己"}

]

}

点击发送,几秒钟后你就能收到AI的回复。就这么简单,不需要安装任何软件,不需要编程知识。

如果你想在代码中使用,Python的例子同样简单:

pythonimport requests import json url = "https://api.laozhang.ai/v1/chat/completions" headers = { "Authorization": "Bearer YOUR_API_KEY", "Content-Type": "application/json" } # 准备问题 data = { "model": "gpt-4o", "messages": [ {"role": "user", "content": "帮我写一首关于春天的诗"} ] } # 发送请求 response = requests.post(url, headers=headers, json=data) result = response.json() # 打印回答 print(result['choices'][0]['message']['content'])

Node.js的版本也很直观:

javascriptconst axios = require('axios'); async function askAI(question) { const response = await axios.post('https://api.laozhang.ai/v1/chat/completions', { model: 'gpt-4o', messages: [{role: 'user', content: question}] }, { headers: { 'Authorization': 'Bearer YOUR_API_KEY', 'Content-Type': 'application/json' } }); return response.data.choices[0].message.content; } // 使用示例 askAI('今天天气如何?').then(console.log);

对于完全不想写代码的用户,还有很多现成的工具可以使用。比如,你可以使用ChatGPT的开源替代界面,只需要填入API地址和密钥就能获得和官方几乎一样的体验。常用的有ChatGPT-Next-Web、ChatBox等,都支持自定义API。

多模型时代:不要局限于ChatGPT

将视野局限在ChatGPT上是一种浪费。2025年的AI领域百花齐放,除了OpenAI的GPT系列,还有很多优秀的模型值得尝试。通过API的方式,你可以轻松体验所有这些模型,找到最适合自己需求的选择。

Claude 3.5 Sonnet是目前最受欢迎的GPT-4替代品之一。在代码生成、逻辑推理、长文本理解等方面,Claude经常能给出比GPT-4更好的结果。特别是在处理复杂的编程任务时,Claude的表现尤其出色。它的上下文窗口达到200K tokens,是GPT-4的25倍,可以一次性处理整本书的内容。

Google的Gemini Pro虽然知名度不如前两者,但在某些特定任务上有独特优势。Gemini的多模态能力很强,可以同时理解文本、图片、音频等多种输入。在处理包含图表、流程图的技术文档时,Gemini的理解能力明显优于纯文本模型。而且Gemini的API价格相对便宜,适合大批量使用。

不同模型的定价策略也不相同。以100万tokens的使用量计算,GPT-4o的成本约为20美元,Claude 3.5约为15美元,而Gemini Pro只需要7美元。对于预算有限的用户,可以根据任务的重要程度选择不同的模型,实现成本优化。

更有趣的是,你可以让多个模型协同工作。比如,用Claude生成代码初稿,用GPT-4进行优化和调试,最后用Gemini生成文档。这种"模型协奏"的方式,能够充分发挥各个模型的优势,获得最佳结果。

通过 LaoZhang-AI 这样的统一API网关,切换模型变得异常简单。只需要修改一个参数,就能在不同模型之间自由切换,所有模型使用相同的接口格式,没有任何学习成本。这种灵活性是订阅制服务无法提供的。

实战案例:各类用户的最佳实践

理论说得再多,不如实际案例来得直观。让我们看看不同类型的用户是如何利用API解决实际问题的。

开发者案例:自动化代码审查系统

张先生是一家科技公司的技术负责人,团队有20多名开发者。之前使用ChatGPT Plus进行代码审查,但账号共享带来很多问题。转向API后,他构建了一个自动化代码审查系统:

pythondef review_code(code_snippet, language="python"): prompt = f""" 请审查以下{language}代码,关注: 1. 潜在的bug和安全问题 2. 性能优化建议 3. 代码风格改进 代码: ```{language} {code_snippet} ``` """ # 使用Claude模型进行代码审查 response = call_api(model="claude-3.5-sonnet", prompt=prompt) return response

系统集成到GitLab的CI/CD流程中,每次提交代码自动触发审查。一个月下来,API成本只有400元,而如果给每个开发者都配ChatGPT Plus,需要2700元。更重要的是,自动化审查提高了代码质量,减少了人工审查的时间。

内容创作者案例:批量内容生成工作流

李女士经营一个科技自媒体,需要大量产出高质量内容。她开发了一套内容生产流水线:

- 使用GPT-4生成文章大纲和初稿

- 用Claude优化文章逻辑和表达

- 通过Gemini检查事实准确性

- 最后人工润色和发布

整个流程通过Python脚本自动化,一天可以产出10篇高质量文章。每篇文章的AI成本约5元,相比雇佣写手,成本降低了90%,而且质量更稳定。

研究团队案例:多模型对比实验平台

某高校AI实验室需要对比不同模型在特定任务上的表现。他们搭建了一个实验平台,可以同时向多个模型发送相同的提示词,然后对比结果:

javascriptasync function compareModels(prompt) { const models = ['gpt-4o', 'claude-3.5-sonnet', 'gemini-pro']; const results = await Promise.all( models.map(model => callAPI(model, prompt)) ); return { prompt: prompt, responses: models.map((model, index) => ({ model: model, response: results[index], responseTime: results[index].latency, tokenCount: results[index].usage.total_tokens })) }; }

通过这个平台,研究团队发现了很多有趣的现象。比如,在数学推理任务上,GPT-4的准确率最高;在创意写作上,Claude的文笔最好;在多语言翻译上,Gemini表现最稳定。这些发现帮助他们为不同的研究项目选择最合适的模型。

风险管理:如何避免再次"踩坑"

野卡跑路给我们的最大教训是:不要把所有鸡蛋放在一个篮子里。在AI服务的使用上,分散风险策略同样重要。

首先是支付方式的多元化。如果你选择继续使用订阅制服务,不要只依赖一种支付方式。可以同时准备iOS充值、虚拟信用卡、代充值等多种渠道。每种方式都少量尝试,不要大额预存。特别是虚拟信用卡平台,坚持"用多少充多少"的原则,降低资金风险。

其次是服务的多元化。不要只依赖ChatGPT Plus,可以同时使用API服务作为备份。即使订阅服务出现问题,也能通过API继续工作。有条件的话,可以同时开通多个AI服务的账号,比如ChatGPT、Claude、Gemini等,互为备份。

建立自己的应急方案也很重要。保存重要的对话记录,定期导出数据。学习基本的API使用方法,以便在紧急情况下快速切换。加入相关的社区和群组,及时获取信息,互通有无。

对于团队用户,建议建立统一的AI服务管理策略。不要让每个成员单独订阅,而是通过API的方式统一管理。这样不仅成本更低,而且便于监控使用情况,避免滥用。同时,建立使用规范和最佳实践,提高整体效率。

未来展望:AI服务的发展趋势

站在2025年中期这个时间点,我们可以看到AI服务领域的几个明显趋势。

订阅制向API化转变是大势所趋。越来越多的用户意识到,API调用的灵活性和成本优势。AI服务商也在优化API体验,降低使用门槛。未来,可能会出现更多面向普通用户的API工具,让技术小白也能轻松使用。

开源模型的崛起值得关注。Meta的Llama系列、Mistral AI的模型等开源选项越来越成熟。虽然性能还比不上闭源的顶级模型,但对于很多应用场景已经足够。未来可能会出现更多基于开源模型的服务,进一步降低AI使用成本。

本地部署可能成为新的选择。随着硬件性能的提升和模型优化技术的进步,在个人电脑上运行AI模型变得越来越可行。对于注重隐私和数据安全的用户,本地部署提供了完全的控制权。当然,这需要一定的技术能力和硬件投入。

监管政策的变化也需要关注。各国对AI服务的监管态度不同,可能会影响服务的可用性。保持对政策动向的关注,及时调整使用策略,是每个AI用户都需要做的功课。

结语

野卡的跑路虽然给很多用户带来了困扰,但也促使我们重新思考AI服务的使用方式。与其继续在灰色地带寻找临时解决方案,不如拥抱更开放、更灵活的API模式。通过本文介绍的各种方案,相信每个用户都能找到适合自己的解决之道。

记住,技术是为人服务的。选择哪种方案,取决于你的实际需求、技术能力和风险承受度。但无论选择什么,都要保持学习的心态,因为AI领域的变化实在太快了。今天的最佳方案,可能明天就会被更好的选择取代。

最后,如果你决定尝试API方式,不妨从 LaoZhang-AI 开始。新用户注册即送10美元额度,足够你充分体验API的魅力。相比每月固定支出135元订阅ChatGPT Plus,按需付费的API模式可能会给你带来惊喜。毕竟,在这个充满变化的时代,灵活性比什么都重要。